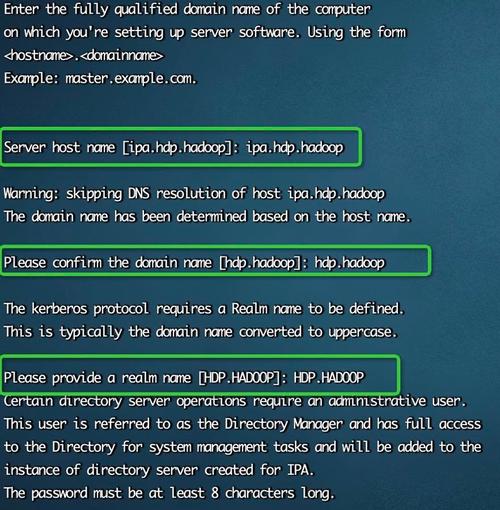

本文摘要: 开源大数据集群部署(四)Freeipa部署(kerberos+ldap)〖1〗、在开源大数据集群部署中,FreeIPA扮演了关键角色,尤其是通过集成Kerberos和LDAP来提升安全性。

开源大数据集群部署(四)Freeipa部署(kerberos+ldap)

〖1〗、在开源大数据集群部署中,FreeIPA扮演了关键角色,尤其是通过集成Kerberos和LDAP来提升安全性。FreeIPA是一个综合的安全信息管理系统,它集成了如Kerberos认证、LDAP数据存储、NTP时钟同步、Bind主机识别等服务,并提供了统一的命令行管理和Web界面,简化了基础设施管理。

〖2〗、命令卸载:使用相应命令卸载FreeIPA服务器及客户端,同时清理残留文件和相关软件包。执行上述命令后,FreeIPA服务器和客户端将被完全卸载,相关残留文件和软件包也会被清理。请注意,在执行这些命令前,务必备份重要数据,并谨慎操作,以免造成数据丢失。

如何架构大数据系统hadoop

Hadoop体系架构 『1』Hadoop最底层是一个HDFS(Hadoop Distributed File System,分布式文件系统),存储在HDFS中的文件先被分成块,然后再将这些块复制到多个主机中(DataNode,数据节点)。

在海量数据下,数据冗余模块往往成为整个系统的瓶颈,建议使用一些比较快的内存NoSQL来冗余原始数据,并采用尽可能多的节点进行并行冗余;或者也完全可以在Hadoop中执行批量Map,进行数据格式的转化。

搭建Hadoop大数据平台的主要步骤包括:环境准备、Hadoop安装与配置、集群设置、测试与验证。环境准备 在搭建Hadoop大数据平台之前,首先需要准备相应的硬件和软件环境。硬件环境通常包括多台服务器或者虚拟机,用于构建Hadoop的分布式集群。软件环境则包括操作系统、Java运行环境等。

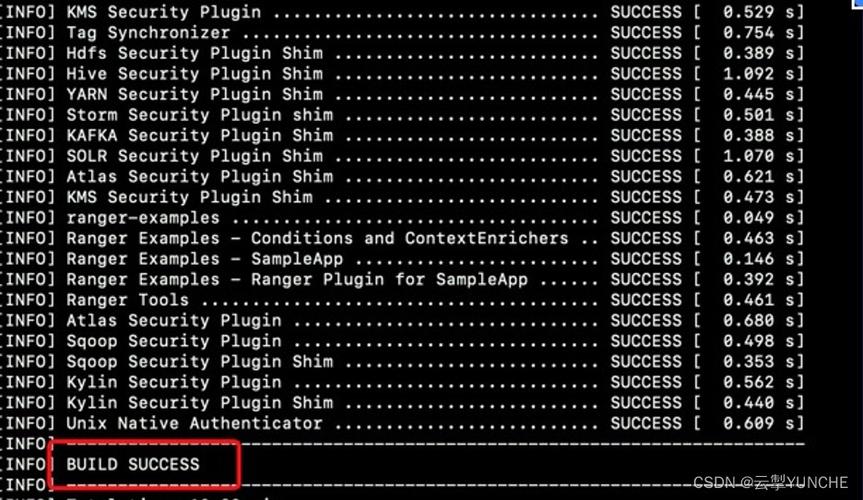

开源大数据集群部署(八)Ranger编译部署

编译ranger 虽未详述二进制包编译过程,但简要说明如下:执行编译后,显示SUCCESS表示成功。生成的二进制包位于target目录下。使用已编译好的二进制包。创建ranger库 在hddtstack.com主机上以mysql权限创建ranger用户。确保将mysql-connector-java.jar放在/usr/share/java目录下。

根据可用的基础计算资源,规划CDH集群规模和数据节点容量,新集群组件组合部署方案。新集群根据节点功能角色,划分为日志分析平台和大数据平台2个集群。新老集群之间万兆网络互通,进行数据同步传输。

数据采集与预处理:FlumeNG实时日志收集系统,支持在日志系统中定制各类数据发送方,用于收集数据;Zookeeper是一个分布式的,开放源码的分布式应用程序协调服务,提供数据同步服务。数据存储:Hadoop作为一个开源的框架,专为离线和大规模数据分析而设计,HDFS作为其核心的存储引擎,已被广泛用于数据存储。

E-MapReduce(EMR)是云原生开源大数据平台,提供高性能、稳定版本的Hadoop、Hive、Spark、Flink、Presto、Clickhouse、Delta、Hudi等开源大数据计算和存储引擎。EMR计算资源可根据业务需求灵活调整,并支持部署在阿里云公有云的ECS和ACK、专有云平台。

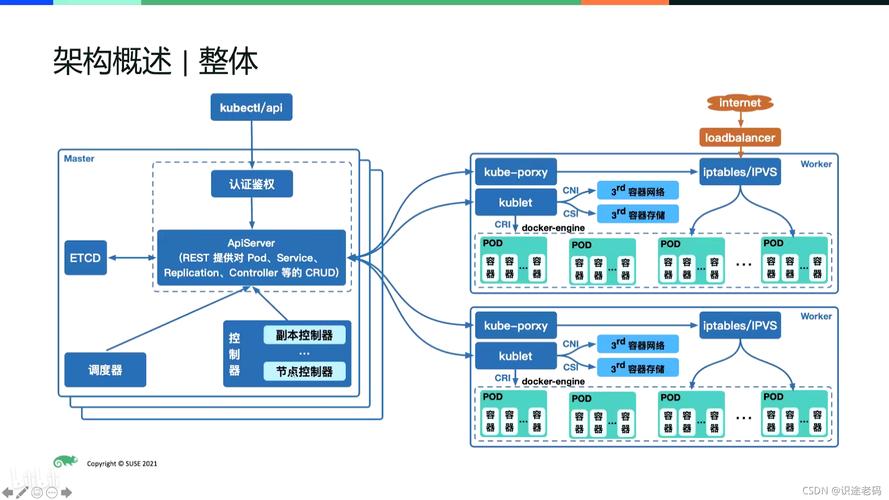

k8s多集群分发方案

工作负载分发:根据配置的调度策略,将工作负载分发到合适的集群上。 监控与管理:对分发的工作负载进行实时监控和管理,确保应用的高可用性和资源的合理分配。

综上所述,Dragonfly2作为K8S多集群镜像分发的解决方案,通过P2P技术优化资源传输,结合Harbor预热机制,显著提升了边缘云架构下的镜像分发效率与稳定性,为解决实际生产环境中的镜像分发挑战提供了有效途径。

在云原生领域,随着业务需求的扩大,k8s多集群分发方案逐渐成为热门话题。尤其对于大型电商和AI大数据处理等场景,常常需要处理超出官方宣称规模的资源需求。同时,跨云厂商部署或私有云与公有云的配合使用也促使多集群解决方案的必要性。多集群环境下的挑战主要包括资源管理和部署策略。

大数据学习笔记:基于docker的大数据集群搭建(二)———搭建zookeeper,hiv...

〖1〗、ZookeeperZookeeper,作为分布式协调服务,为分布式应用提供关键的协调和配置维护功能,确保系统的稳定性和效率。它就像一个分布式文件系统,支持数据同步、发布/订阅和集群节点协调,广泛应用于服务注册、配置管理、分布式锁和队列等场景,是构建复杂分布式应用的核心组件。

〖2〗、分享大数据学习路线:第一阶段为JAVASE+MYSQL+JDBC主要学习一些Java语言的概念,如字符、bai流程控制、面向对象、进程线程、枚举反射等,学习MySQL数据库的安装卸载及相关操作,学习JDBC的实现原理以及Linux基础知识,是大数据刚入门阶段。

〖3〗、首先,构建bin/jdk:8u221镜像,借鉴-- docker基础环境搭建,构建bin/zookeeper:7镜像,借鉴-- docker环境,搭建zookeeper集群。kafka集群由zookeeper管理,创建kafka-net docker网络并启动zookeeper集群。这里使用单机zookeeper简化部署。

〖4〗、学习大数据首先要学习Java基础 Java是大数据学习需要的编程语言基础,因为大数据的开发基于常用的高级语言。

〖5〗、在大数据培训班主要培训内容有:课程内容教学。不同的培训机构,根据课程内容的不同,当然时间也会有所差异,学习内容大概为Java语言基础、HTML、CSS、JavaWeb和数据库、Linux基础、Hadoop生态体系、Spark生态体系等课程内容。项目实战训练。参加【大数据培训】必须经过项目实战训练。

〖6〗、大数据分析挖掘与处理、移动开发与架构、软件开发、云计算等前沿技术等。主修课程:面向对象程序设计、Hadoop实用技术、数据挖掘、机器学习、数据统计分析、高等数学、Python编程、JAVA编程、数据库技术、Web开发、Linux操作系统、大数据平台搭建及运维、大数据应用开发、可视化设计与开发等。

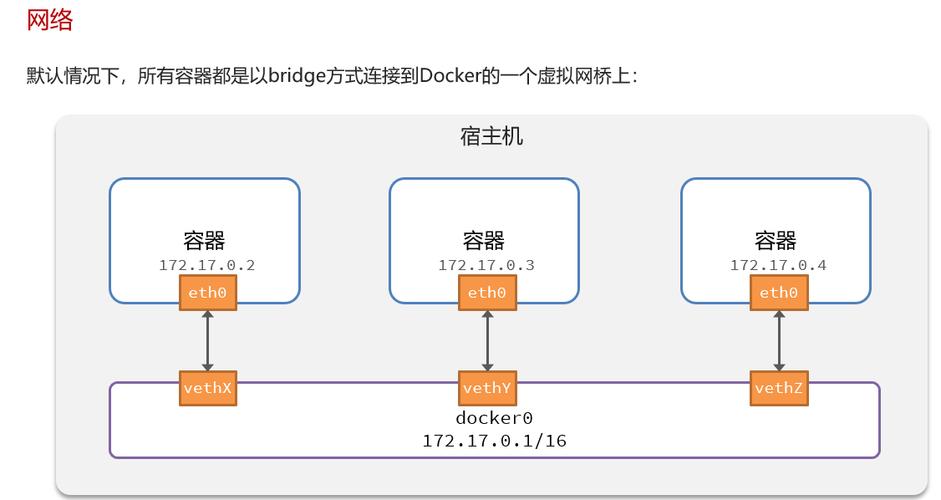

Hadoop-Spark-Hive集群在Docker进行容器化运行

〖1〗、在大数据学习中,搭建Hadoop、Spark、Hive集群通常需要虚拟机环境,这耗时耗力,对配置要求较高,易导致电脑卡死。Docker容器技术的出现提供了新的解决方案,它允许以轻量级方式部署这些组件。本文将指导您如何在Docker中容器化部署Hadoop、Spark、Hive集群。

〖2〗、首先,我们通过Docker镜像启动容器环境。在容器中,我们可以看到一个由Master、Slave1和Slave2组成的三台虚拟机器集群。通过/etc/profile环境变量配置文件,我们查看到了Hadoop的安装目录。

〖3〗、部署步骤选取Zookeeper(10版本)、Hive(3版本)和MySQL驱动(0.32版本)。安装并配置Zookeeper:上传到Docker容器,配置文件解释与同步。YARN历史服务启动:修改配置并启动JobHistoryServer。Hive内嵌模式部署:在Hadoop02上初始化,注意内嵌模式的特定配置。

Clickhouse集群部署(3分片2副本)

〖1〗、下面进行Clickhouse的RPM包安装,这是在Linux系统中部署Clickhouse的常用方式。安装完成后,修改配置文件以适应3分片2副本的部署策略,确保数据分布的均衡与冗余。最后,启动Clickhouse集群。验证集群状态,确保所有节点运行正常,数据复制与查询功能均能正常运作。

〖2〗、个节点部署,可以选取2个分片0个副本,只需在config.xml中进行设置,具体步骤见附3。在这种模式下,数据通过分片分散在多个节点上,提高存储能力。副本则强化了数据安全性,即使某节点故障,也能从其他节点获取数据。

〖3〗、分布式DDL语句支持在分布式ClickHouse集群中执行创建、删除、重命名和修改表等操作。使用特定语法格式,结合集群名称和表名称,分布式DDL语句能在集群中各个节点上并行执行。例如,创建具有3个分片和1个副本的表“person_score”,需配置集群并执行建表命令。表创建后,可在Zookeeper中查看分片信息。

〖4〗、使用Docker-compose在本地搭建clickhouse集群,配置不同的端口以区分服务。创建三个容器挂载文件夹,在/data/ckconfig目录下编写配置文件,以clickhouse01为例,确认端口号。配置zookeeper和remote_servers,对于两个分片集群,每个分片内配置两个副本以实现数据冗余。使用docker-compose up -d命令启动Docker容器。

如何为大数据处理构建高性能Hadoop集群

〖1〗、每一个Hadoop数据节点的目标都必须实现CPU、内存、存储和网络资源的平衡。如果四者之中的任意一个性能相对较差的话,那么系统的潜在处理能力都有可能遭遇瓶颈。添加更多的CPU和内存组建,将影响存储和网络的平衡,如何使Hadoop集群节点在处理数据时更有效率,减少结果,并在Hadoop集群内添加更多的HDFS存储节点。

〖2〗、Hadoop的核心是MapReduce(映射和化简编程模型)引擎,Map意为将单个任务分解为多个,而Reduce则意为将分解后的多任务结果汇总,该引擎由JobTrackers(工作追踪,对应命名节点)和TaskTrackers(任务追踪,对应数据节点)组成。

〖3〗、集群搭建步骤包括安装Hadoop、配置环境变量、设置核心配置文件,以及初始化集群。初始化集群时,需执行一系列命令,如格式化ZK、启动JournalNode、进行NameNode格式化及启动,并通过`bootstrapStandby`确保Standby状态的NameNode同步。至此,HA集群初始化完成,后续可通过启动脚本快速管理集群。

〖4〗、Hadoop的数据在集群上均衡分布,并通过复制副本来确保数据的可靠性和容错性。因为数据和对数据处理的操作都是分布在服务器上,处理指令就可以直接地发送到存储数据的机器。这样一个集群的每个服务器器上都需要存储和处理数据,因此必须对Hadoop集群的每个节点进行配置,以满足数据存储和处理要求。

〖5〗、其次利用Hadoop MapReduce强大的并行化处理能力,无论OLAP分析中的维度增加多少,开销并不显著增长。换言之,Hadoop可以支持一个巨大无比的Cube,包含了无数你想到或者想不到的维度,而且每次多维分析,都可以支持成千上百个维度,并不会显著影响分析的性能。

〖6〗、搭建Hadoop大数据平台的主要步骤包括:环境准备、Hadoop安装与配置、集群设置、测试与验证。环境准备 在搭建Hadoop大数据平台之前,首先需要准备相应的硬件和软件环境。硬件环境通常包括多台服务器或者虚拟机,用于构建Hadoop的分布式集群。软件环境则包括操作系统、Java运行环境等。

大数据集群部署方案和大数据集群部署方案怎么写的介绍到此就结束了,如果能碰巧解决你现在面临的问题,别忘了关注本站,如果你还想了解更多这方面的信息,记得收藏关注本站,更多关于大数据集群部署方案怎么写的信息别忘了在本站进行查找喔。

还木有评论哦,快来抢沙发吧~