本文摘要: 汉语在线分词,有哪些网站或者工具可以直接看分词效果?在国内大数据中文分词工具中,NLPIR大数据语义智能分析平台、哈工大语言云(LTP)、《同义词词林》扩展版及结巴分词都是值得关注的工具。以下分别介绍它们各自的优势及功能。

汉语在线分词,有哪些网站或者工具可以直接看分词效果?

在国内大数据中文分词工具中,NLPIR大数据语义智能分析平台、哈工大语言云(LTP)、《同义词词林》扩展版及结巴分词都是值得关注的工具。以下分别介绍它们各自的优势及功能。

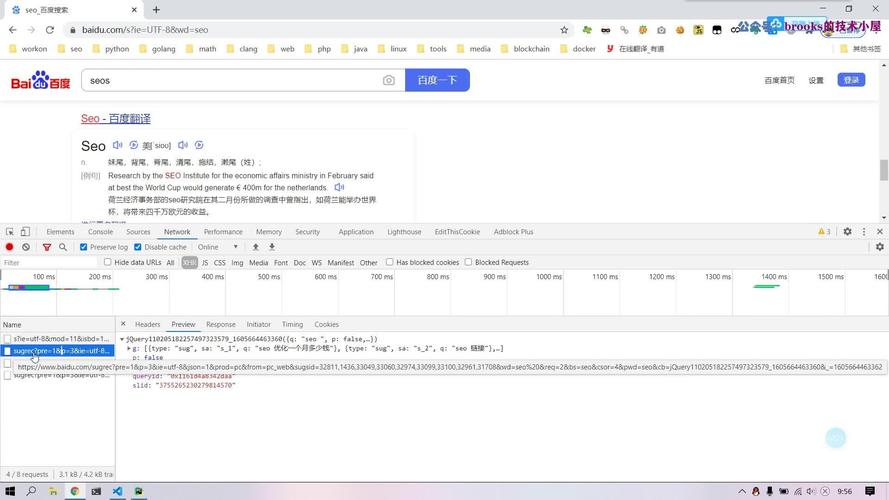

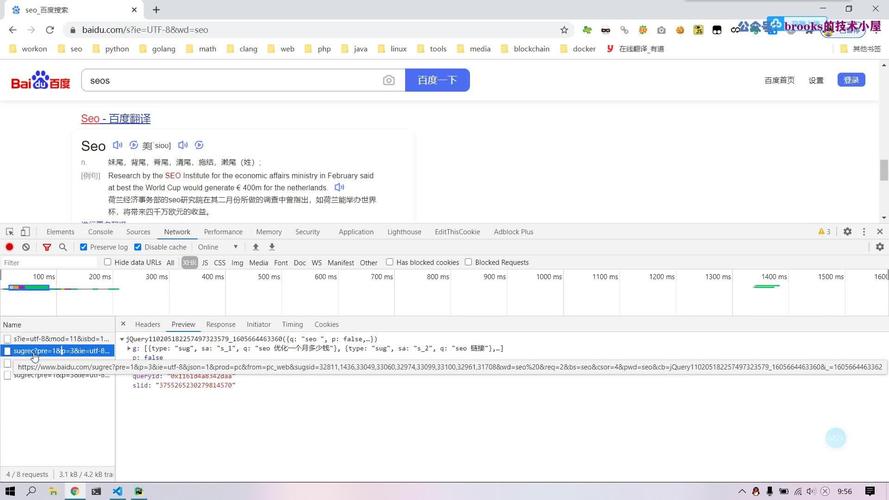

中文分词工具推荐:腾讯的TexSmart,结巴,LTP TexSmart,由腾讯开发,提供在线演示及API调用。API调用时需注意,若使用代理需关闭,否则会出错。返回结果为JSON格式,word_list字段可视为分词结果。结巴,提供详细使用方法,安装方式有全自动、半自动和手动三种。分词代码简洁易懂。

Jieba:Jieba是Python中使用广泛的中文分词工具,支持精确、全模式、搜索引擎模式,包含繁体分词和自定义词典。其原理基于词典分词,对未在词典内的词,使用HMM算法识别新词。Jieba采用动态规划算法,通过有向无环图查找,使得词的切割组合联合概率最大,再利用HMM算法进行二次分词,即新词识别。

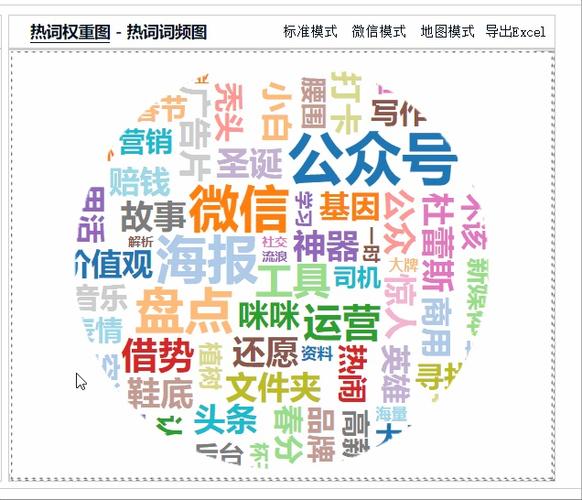

做关键词分析,我有4款免费词云工具

〖1〗、首先,nlpir大数据平台尽管界面复古,但功能强大,能进行深度分析,包括词频统计和词向量模型,尤其适合需要深度挖掘文本信息的场景。词云生成随机性较大,不适用于只想做基础词云的用户。图悦工具支持大量文本输入,并提供Excel报告,对数据分析需求较高的用户而言十分实用。

〖2〗、ToCloud:作为一款免费的在线标签云生成器,ToCloud允许用户设置词的长度和频率,以生成符合要求的词云图。它可能还具备提取短语的功能,有助于用户更准确地理解文本中的关键词。 Wordle:虽然Wordle最初可能是一款游戏工具,但它也具备生成词云图的功能。

〖3〗、首先,国外的Wordle以其快速分析文本和多种风格的展示而受欢迎,但仅限于英文。Wordle.net 提供简洁的界面,支持文字字体和颜色自定义,生成的词云图可以保存分享。然而,对于中文用户,需要先进行英文转换。WordItOut的易用性值得一提,它直观地生成词云,但不支持中文。

怎么进行文本的情感分析?

总结,情感分析是自然语言处理领域中的一项关键技术,通过量化文本情感内容,帮助我们理解和预测人类行为。利用先进的技术和算法,情感分析能够为商业决策、社会研究等领域提供有力支持。尽管方法存在局限性,但通过不断改进和创新,情感分析的应用潜力将持续增长。

定义感情基调 感情基调是文本所表现出的主要情感氛围或情感倾向。在文本分析中,感情基调可以帮助读者快速理解文本的主题和情感表达。积极感情基调 积极感情基调表现为文本中充满了愉悦、欢乐、希望等积极的情感色彩。

基于词典的文本情感分析方法依赖情感词典,利用其极性和强度标注进行文本情感分类。首先对文本进行分词,然后将每个词与情感词典对应,计算正负得分,最终得出文本情感极性。构建情感词典的方式有两种:人工构建和自动构建。

其次,进行词频分析,提取与米饭相关的高频词,如“米饭”、“白饭”等,使用同义词替换提高数据准确性。在中文通用分析中,利用特征词表分析文本主题,如“味道”、“口感”等,通过关键词云图和共现词列表进一步挖掘关键点。

神经网络也是进行情感分析的一种方法,尤其在处理文本时。这种方法通常以字符为单位训练神经网络,无需预先了解语法和语义知识,但需要较大规模的训练集。这种方法已经在情感分析领域取得了较好的效果,相关论文可以在arxiv.org上找到。实现文本情感分析并不复杂,可以使用现成的工具。

情感分析是一种通过自然语言处理技术来识别、提取和量化文本中的情感倾向的方法。Python在这一领域有着丰富的库和工具,如NLTK、TextBlob和VADER等。本文将介绍如何使用Python进行情感分析,并通过可视化展示结果。首先,我们需要安装一些必要的Python库。

NLPIR大数据搜索与挖掘共享平台的有哪些优势,好用吗,谁用过,求回答_百...

〖1〗、技术优势 NLPIR由专注于大数据科学研究与工程应用融合领域的十多名博士硕士,倾力15年,持续创新而构建,该平台分别获得了2010年钱伟长中文信息处理科学技术奖一等奖,世界与国内公开第三方的独立评测综合第一名。综合平衡了效果与效率,实现了 “又好又快”的技术追求。

〖2〗、NLPIR实体抽取系统能够智能识别文本中出现的人名、地名、机构名、媒体、作者、及文章的主题关键词,这是对语言规律的深入理解和预测,并且其所提炼出的词语不需要在词典库中事先存在。

〖3〗、打开微信应用,进入首页; 点击右上角的“我”图标,进入“我”的页面; 在“我”的页面中,点击“设置”图标,在下拉菜单中选取“通用”; 在“通用”页面中,选取“功能”选项; 在“功能”菜单中,找到“自动文案”选项并打开它即可。

〖4〗、了解和定位客户 这是大数bai据近来最广du为人知的应用领域。很多企业热衷于社交zhi媒体数据dao、浏览器日志、文本挖掘等各类数据集,通过大数据技术创建预测模型,从而更全面地了解客户以及他们的行为、喜好。

〖5〗、大数据指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的数据集合。

语义分割,语义是怎么体现?为何叫语义?

〖1〗、语义分析是自然语言处理中的关键环节,其目的是揭示文本中的深层含义,不仅包括词语的字面含义,还涉及词语间的逻辑关系。分析语义的起点是词语,通过解析词语的含义与它们之间的联系,为后续的应用如信息抽取、机器翻译等提供基础。在篇章层面,语义分析旨在提取文本的主题和类别,助力大规模文本的管理和挖掘。

〖2〗、语义分割是一种计算机视觉问题,其涉及将一些原始数据(例如,平面图像)作为输入并将它们转换为具有突出显示的感兴趣区域的掩模。 许多人使用术语全像素语义分割(full-pixel semantic segmentation),其中图像中的每个像素根据其所属的感兴趣对象被分配类别ID。

〖3〗、语义分割是计算机视觉中很重要的一个方向。不同于目标检测和识别,语义分割实现了图像像素级的分类。它能够将一张图片或者视频(视频以帧来提取的话其实就是图片),按照类别的异同,将图像分为多个块。如下图所示:明白了分割就是将图像按类别划分为不同的块,那么我们如何来理解语义这个词语呢。

自然语言处理和文本挖掘的关系

〖1〗、所以自然语言处理与文本挖掘是相互包含关系,可以相互联系相互影响。而北京理工大学大数据搜索与挖掘实验室张华平主任研发的NLPIR大数据语义智能分析技术是满足大数据挖掘对语法、词法和语义的综合应用。

〖2〗、自然语言处理(NLP) 关注的是人类的自然语言与计算机设备之间的相互关系。NLP是计算机语言学的重要方面之一,它同样也属于计算机科学和人工智能领域。而 文本挖掘 和 NLP 的存在领域类似,它关注的是识别文本数据中有趣并且重要的模式。但是,这二者仍有不同。

〖3〗、自然语言处理工具和机器学习工具的结合,使得文本挖掘变得更加便捷和高效。用户可以通过这些工具,对海量的文本数据进行预处理、特征提取、模型训练和结果分析,从而实现对文本数据的深入理解和挖掘。无论是企业还是研究机构,都可以借助这些工具,提高文本数据处理的效率和准确性。

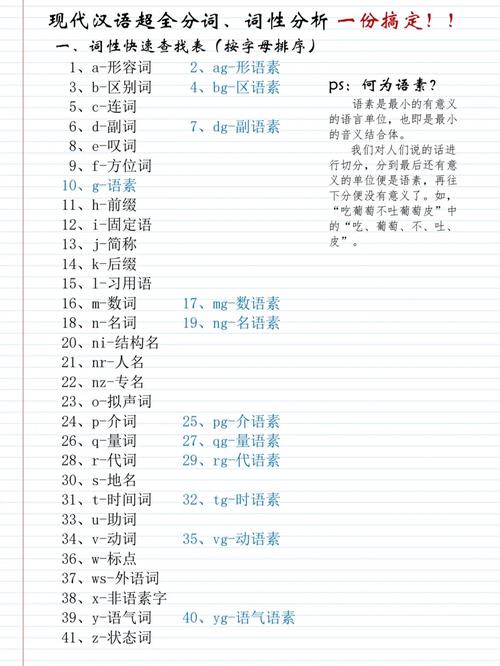

〖4〗、自然语言处理技术是一种让计算机理解和处理人类语言的技术。在文本挖掘中,NLP技术主要用于文本预处理、文本分析和文本理解等阶段。这包括分词、词性标注、命名实体识别、句法分析、语义分析等任务。NLP技术可以有效地从文本中提取关键信息,提高文本挖掘的效率和准确性。

〖5〗、作文本挖掘需要学习NLP,因为你需要处理文本,提取出你感兴趣的信息。如果你对机器学习熟悉,学习statistical NLP还是比较容易的。另外,也需要补充一些语言学基础知识。

〖6〗、借鉴文献自动生成方法主要是基于文本挖掘和自然语言处理技术。它通过分析和识别文献中的关键信息,如作者、标题、出版年份等,从而自动化地生成借鉴文献列表。基于文本挖掘的借鉴文献自动生成 这种方法的核心在于使用文本挖掘技术从大量文献中识别和提取关键信息。

如何利用pynlpir进行中文分词并保留段落信息

开始使用pynlpir进行分词。基础分词步骤是通过命令展示结果,批量分词则需结合os模块读取目录内txt文件,每段文本分词并标注,词与标注信息以【_】连接,两词间用【|】分隔,段落间加入换行,最后将处理结果保存至【seg_】开头的txt文件中。采用英文标注,每完成一个文件生成新文件。最终代码如下图所示。

nlpir大数据分析和rnn大数据分析的介绍到此就结束了,如果能碰巧解决你现在面临的问题,别忘了关注本站,如果你还想了解更多这方面的信息,记得收藏关注本站,更多关于rnn大数据分析的信息别忘了在本站进行查找喔。

还木有评论哦,快来抢沙发吧~