本文摘要: 大数据(HDFS)面试题及答案HDFS组成架构NameNode管理文件元数据,如路径、属性及块列表。DataNode存储文件块数据及校验和。SecondaryNameNode定期备份NameNode元数据。2HDFS优缺点优点:适合大数据存储,缺点:不适合网盘应用。

大数据(HDFS)面试题及答案

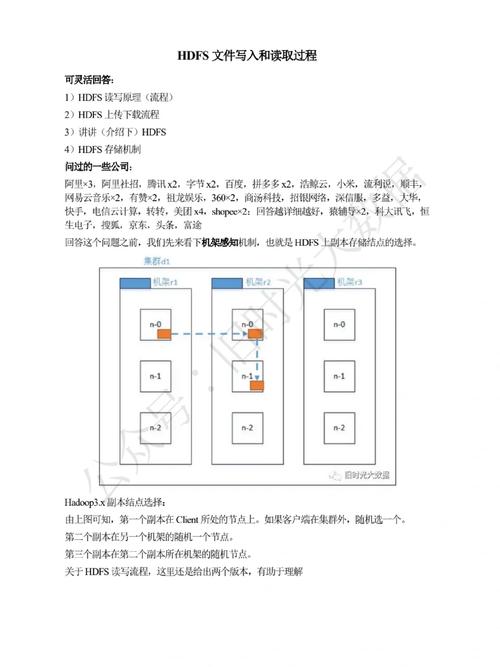

HDFS组成架构 NameNode管理文件元数据,如路径、属性及块列表。DataNode存储文件块数据及校验和。Secondary NameNode定期备份NameNode元数据。2 HDFS优缺点 优点:适合大数据存储,缺点:不适合网盘应用。HDFS是分布式文件系统,用于存储文件,通过目录树定位文件。

在HDFS中,文件物理上是分块存储的,块的大小可以通过配置参数( dfs.blocksize)来规定。默认大小在hadoopx版本中是128M,老版本中是64M。块大小不能设置得太小或太大。块的大小应足够大以减少寻址开销,同时考虑到磁盘传输速率。

数据一致性检查与维护 fsck是HDFS的检查工具,用于检测数据完整性问题,确保数据一致性。在面试中,不仅要熟悉这些概念,还要能清晰地阐述自己的经验,例如: 实战经验与问题准备 分享你的项目经验,强调成功案例,同时准备针对大数据分析、配置管理等的专业问题和答案。

大数据和Hadoop几乎是同义词。随着大数据的兴起,专门从事大数据操作的Hadoop框架也开始流行起来。专业人员可以使用该框架来分析大数据并帮助企业做出决策。注意: 这个问题通常在大数据访谈中提出。 可以进一步去回答这个问题,并试图解释的Hadoop的主要组成部分。

HDFS的容错机制包括故障检测、数据复制和数据完整性检查。故障检测通过心跳信号确保DataNode的正常运行。数据复制确保数据的冗余存储,提高容错性。数据完整性通过总和检验码和定期数据块报告检查。HDFS的基础概念包括Block、NameNode、DataNode和Secondary NameNode。Block是HDFS存储单元,默认大小为64M或128M。

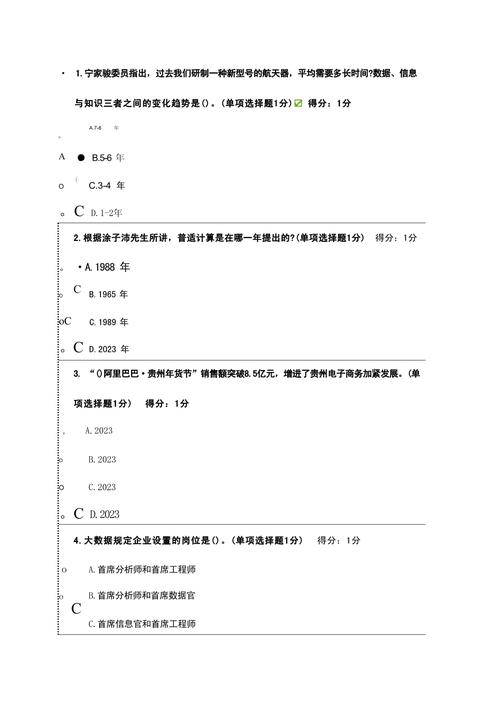

基本的大数据面试问题和答案(50个)

〖1〗、答案:使用coalesce()和repartition()方法降低并行度,新增并行度为1的任务合并小文件。Flink篇 问题:Flink实现流批一体 答案:Flink通过一个引擎支持DataSet和DataStream API,实现计算上的流批一体。Kafka篇 问题:Kafka实现精准一次性 答案:0.11版本后引入幂等性,确保重复数据只持久化一条。

〖2〗、大数据的本质与特性 大数据是处理海量、高速增长和多样性的数据,以提取价值和驱动业务决策的关键工具。其五大特征,Volume(数据量)、Velocity(速度)、Variety(多样性)、Veracity(准确性)和Value(价值),是理解其核心的关键。

〖3〗、您对大数据一词有什么了解? 大数据是与复杂和大型数据集相关的术语。关系数据库无法处理大数据,这就是为什么使用特殊的工具和方法对大量数据执行操作的原因。大数据使公司能够更好地了解其业务,并帮助他们从定期收集的非结构化和原始数据中获取有意义的信息。

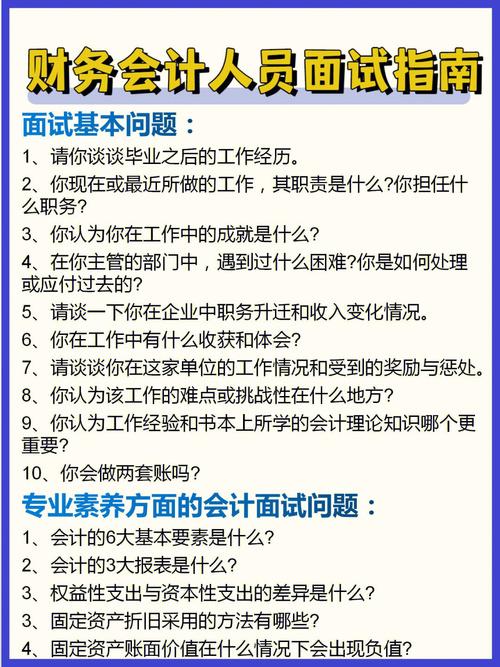

常见大数据公司面试问题有哪些?

〖1〗、你自身最大的优点是什么 这个问题不限于大数据培训面试中,在各行各业的面试中经常出现。可是应聘者不清楚自己的优点是什么,甚至不少人喜欢说我最大的优点是没有缺点。如果面试官听到这样的回那么结果可能是被pass掉。

〖2〗、你自身的优点 这个问题不仅仅是在大数据面试当中常常被问,在各行各业的面试中都经常出现。所以面试者要尽可能说一些和工作相关的优点,比如“学习能力强”“能抗住压力”等,再举一个自己之前工作的例子进行证明,这会让面试官觉得很真实。

〖3〗、您对大数据一词有什么了解? 大数据是与复杂和大型数据集相关的术语。关系数据库无法处理大数据,这就是为什么使用特殊的工具和方法对大量数据执行操作的原因。大数据使公司能够更好地了解其业务,并帮助他们从定期收集的非结构化和原始数据中获取有意义的信息。

大数据面试大厂真题【附答案详细解析】

〖1〗、答案:Flink通过一个引擎支持DataSet和DataStream API,实现计算上的流批一体。Kafka篇 问题:Kafka实现精准一次性 答案:0.11版本后引入幂等性,确保重复数据只持久化一条。利用主键序号缓存,相同序号的消息只会持久化一次。跨会话精准一次性通过事务机制保证。

〖2〗、内部表与外部表的区别在于内部表未使用external修饰符,外部表则使用。关键区别在于外部表不会改变其引用的HDFS文件,而内部表会更新其元数据以反映任何更改。 Hive在0版本前支持索引,但功能有限且效率不高,因此不常使用。索引适用于静态字段,以免频繁重建。

〖3〗、中国联通校招对象面向24届同学,提供技术岗与业务岗两大类岗位,包括但不限于网络安全、未来网络、云计算、大数据、物联网、人工智能、区块链、绿色低碳等方向及市场营销、客户运营、产品管理、解决方案等业务岗位,每位毕业生可投递至2家单位,每个单位比较多2个岗位,具体以各招聘单位职位为准。

〖4〗、【Web全栈式课程】。Node.JS贯穿学习,Vue.JS、Angular、React.JS生态圈三大框架全囊括,掌握Web全栈脉络。项目贯穿式授课。7大项目阶段贯穿学习,掌握企业真实项目开发顺序,对接企业真实工作需求,培养学员从0到1项目思维。大厂面试真题串讲。

〖5〗、在具体打分中,可根据细则灵活判断。【打分五类标准】第一类:41-50分 内容切题,符合题目规定话题要求,针对性、辩证性强。论点正确、见解深刻,论据充分有力,论证严密,内容全面充实,论政清晰、条理清晰,以论为主。体现申论的文体特点。语言准确流畅,文面整洁,书写工整。

史上最全大数据面试题,你有吗?

编程模型方面 Spark基于批处理模型,它将连续数据流分解成微批处理,并在每个微批中执行操作。Flink则采用数据流模型,支持连续和有限数据处理。Flink提供DataStream API,类似于Spark RDD,但更注重事件顺序。数据处理模式 Spark Streaming在微批处理模式下,存在秒级延迟。

答案:完整性、准确性、一致性和及时性是数据质量的四大方面。完整性确保数据完整,准确性避免错误信息,一致性在大体系中保持数据统一,及时性确保数据价值。大数据场景篇 问题:找出1亿个整数中最大的10000个数 答案:全局排序内存不足,分治法和小顶堆是解决方案。

Hadoop的应用与优势 Hadoop擅长处理大量数据,其开源特性使其在企业环境中广受欢迎,尤其是在性能和经济性方面。 数据一致性检查与维护 fsck是HDFS的检查工具,用于检测数据完整性问题,确保数据一致性。

大数据和Hadoop几乎是同义词。随着大数据的兴起,专门用于大数据操作的Hadoop框架也开始流行。专业人士可以使用该框架来分析大数据并帮助企业做出决策。注意: 在大数据采访中通常会问这个问题。 可以进一步去回答这个问题,并试图解释的Hadoop的主要组成部分。

你准备好面试了吗?这里有一些面试中可能会问到的问题以及相对应的答案。集群的最主要瓶颈是磁盘IO。Hadoop运行模式有单机版、伪分布式模式、完全分布式模式。Hadoop生态圈的组件包括:Zookeeper:是一个开源的分布式应用程序协调服务,基于zookeeper可以实现同步服务,配置维护,命名服务。

大数据岗位Spark面试题总结附答案

答案:RDD,即Resilient Distributed Dataset,是Spark的基本数据抽象,代表一个不可变、可分区的并行计算集合。RDD中的数据可在内存或磁盘中存储,分区的结构可动态调整。面试题4:列举并比较Spark中常用算子的区别。

面试题来源:可1)Spark内存管理的结构;2)Spark的Executor内存分布(借鉴“内存空间分配”)堆内和堆外内存规划 作为一个JVM 进程,Executor 的内存管理建立在JVM的内存管理之上,Spark对JVM的堆内(On-heap)空间进行了更为详细的分配,以充分利用内存。

借鉴答案:Spark运行流程以SparkContext为总入口。在SparkContext初始化时,Spark创建DAGScheduler和TaskScheduler以进行作业和任务调度。运行流程概览如下:1)当程序提交后,SparkSubmit进程与Master通信,构建运行环境并启动SparkContext。SparkContext向资源管理器(如Standalone、Mesos或YARN)注册并申请执行资源。

大数据开发面试题及答案和大数据开发面试题及答案大全的介绍到此就结束了,如果能碰巧解决你现在面临的问题,别忘了关注本站,如果你还想了解更多这方面的信息,记得收藏关注本站,更多关于大数据开发面试题及答案大全的信息别忘了在本站进行查找喔。

还木有评论哦,快来抢沙发吧~